Sept photos pour les identifier tous...

En collaboration avec l'entreprise SABIlab (qui propose un soutien en analyse d'image aux laboratoires), des physiciens et physiciennes ont développé DiSTNet2D, un nouvel outil d'analyse d'image conçu pour améliorer significativement l'analyse de séquences d'images, qui s'appuie une architecture avancée de réseau neuronal profond pour analyser les vidéos en utilisant le contexte temporel.

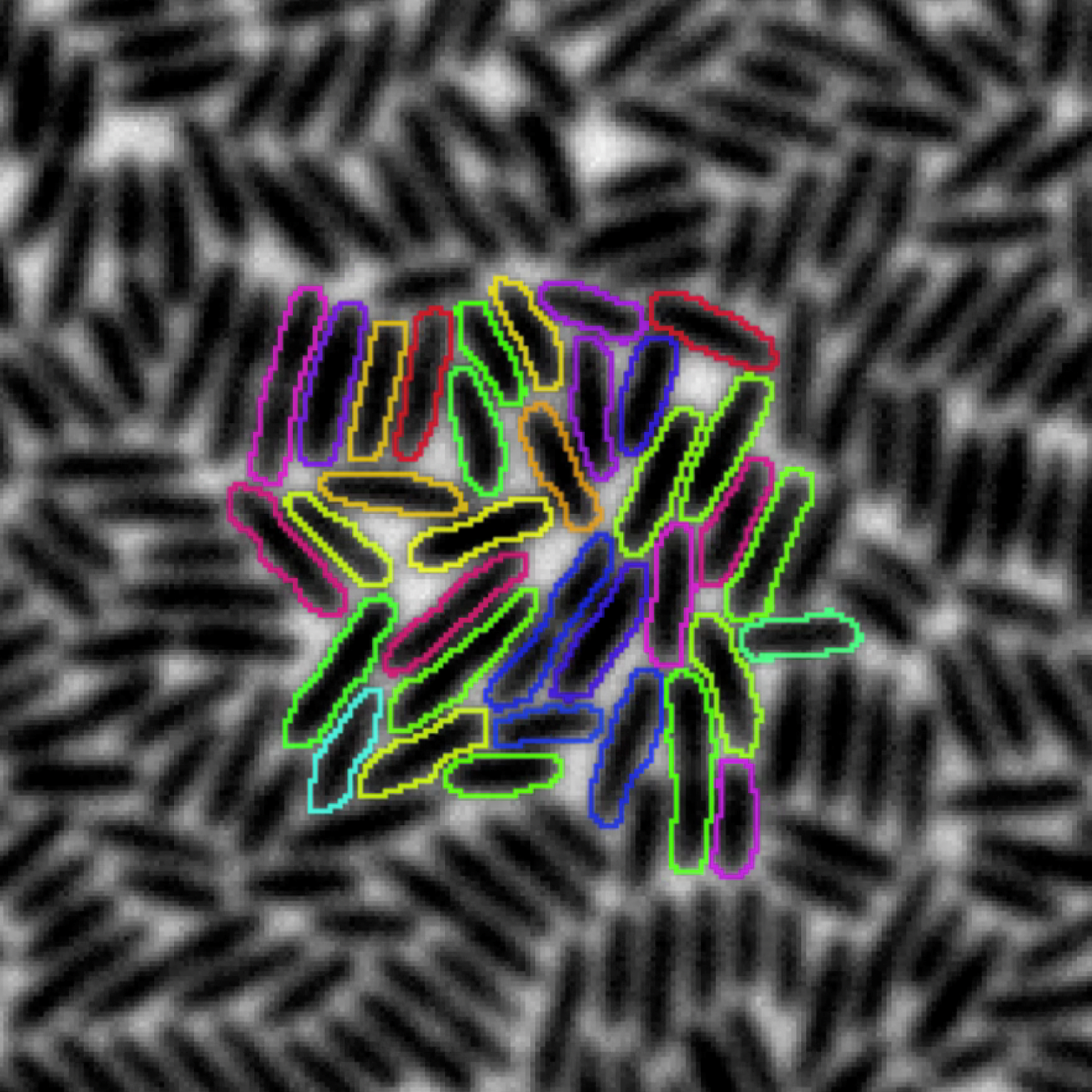

Dans le domaine en évolution rapide des algorithmes d'analyse d'image, la précision dans l'identification et le suivi d'objets au sein de vidéos est fondamentale pour un large éventail d'applications, allant de la physique des systèmes complexes à la recherche biomédicale. Cependant, ces tâches sont souvent difficiles à réaliser fidèlement, et les méthodes traditionnelles se heurtent souvent à des problèmes significatifs. Les techniques habituelles se concentrent en effet sur l'analyse image par image pour repérer les objets, une procédure qui se révèle imprécise dès que les objets sont très proches les uns des autres, ou que les conditions d'observation ne sont pas optimales.

Des chercheurs et chercheuses du Laboratoire Jean Perrin (LJP, CNRS / Sorbonne Université) et du Laboratoire Physique des Cellules et Cancer (PCC, CNRS / Institut Curie / Sorbonne Université), en collaboration avec l'entreprise SABIlab (qui propose un soutien en analyse d'image aux laboratoires), ont développé DiSTNet2D, un nouvel outil d'analyse d'image conçu pour améliorer significativement l'analyse de séquences d'images. Leur approche repose sur un constat simple : si les objets sont difficiles à distinguer sur des images individuelles, il est parfois possible pour les algorithmes de « comprendre » où sont les objets en analysant de concert les images précédentes et les images suivantes (3 photos avant le cliché courant, plus trois photos après), c'est-à-dire en "jouant la vidéo". DiSTNet2D s'appuie une architecture avancée de réseau neuronal profond pour analyser les vidéos en utilisant le contexte temporel – en d’autres termes, il apprend à reconnaître les objets à partir de séquences d'images plutôt que d'images isolées. Cette approche permet une reconnaissance et un suivi des objets nettement plus précis et efficaces, même dans des conditions difficiles. L'architecture permet également de détecter les événements de fusion et ou séparation d'objets, comme dans le cas d'une division cellulaire par exemple.

Les performances de DistNet2D ont été rigoureusement testées sur des images de cellules de mammifères et de bactéries, où il a non seulement surpassé les méthodes concurrentes, mais a également démontré une vitesse de calcul accrue. Ces résultats démontrent l'efficacité et la rapidité de DistNet2D, représentant une avancée notable dans le domaine de l'analyse d'image. De plus, DistNet2D est mis à disposition du public via Bacmman, un plugin d'ImageJ (un logiciel libre d’analyse d’images largement utilisé dans la communauté scientifique), offrant ainsi aux scientifiques la liberté de l'utiliser et de l'entraîner sur de nouvelles données. Cette initiative souligne l'engagement des chercheurs et chercheuses à partager des outils de recherche avancés avec la communauté scientifique et au-delà. Ces résultats sont publiés dans la revue PRX Life.

Références

DiSTNet2D: Leveraging Long-Range Temporal Information for Efficient Segmentation and Tracking, Jean Ollion, Martin Maliet, Caroline Giuglaris, Élise Vacher, and Maxime Deforet, PRX Life 2, publié le 16 avril 2024.

Doi : 10.1103/PRXLife.2.023004

Archive ouverte : arXiv